La qualité des données est bien plus qu’un simple impératif ; c’est un pilier essentiel pour garantir le succès et la pérennité des entreprises. Disposer d’une donnée de qualité, c’est garantir des analyses fiables, des prises de décisions avisées, et éviter des erreurs et pertes dommageables.

C’est pourquoi il est impératif d’avoir une confiance absolue en la qualité de ces données avant de les exploiter ou de les diffuser.

La qualité des données ne se limite pas seulement à leur exactitude technique, mais également à leur adéquation avec les besoins spécifiques des utilisateurs métiers. Les données erronées ou non mises à jour peuvent non seulement altérer la performance opérationnelle, mais aussi compromettre la réputation et la compétitivité de l’entreprise.

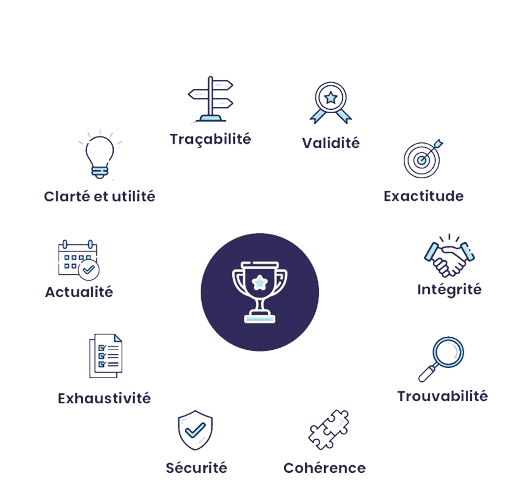

Pour mesurer cette qualité, deux types de règles sont essentiels : les règles techniques et les règles métier. Les règles techniques évaluent des critères intrinsèques à la donnée, tels que la complétude, la validité et la fraîcheur. Tandis que les règles métier complètent cette évaluation en définissant une valeur fonctionnelle à la donnée, en assurant sa cohérence et son accessibilité selon son utilisation spécifique.

Gregory, notre expert data, répond à toutes nos questions :

Pourquoi la qualité des données est-elle si cruciale dans le domaine de la veille concurrentielle et tarifaire ?

→ Nos clients veulent pouvoir s’appuyer sur des données fiables dans leur processus de prise de décisions.

Comment Retail Shake s’assure-t-elle de la fiabilité et de l’exactitude des données qu’elle collecte et analyse ?

→ En plus des vérifications manuelles à chaque étape du raffinage de la donnée,le ‘datacrop’ se charge des derniers contrôles avant enregistrement en base.

Quels sont les indicateurs clés de qualité des données que tu surveilles et comment les améliores-tu continuellement ?

→ Principalement le nombre d’items collectés par chaque spider. Des graphes organisés par secteurs d’activités nous aident lors de nos contrôles.

Une granularité plus fine de ces indicateurs vont nous aider à mieux mesurer la qualité de nos campagnes de collectes.

Quel cycle utilises-tu pour gérer la qualité des données ?

– Tests du scraping en local sur un périmètre restreint ;

– Écriture de tests automatiques des données extraites par chaque spider;

– Création d’un dashboard sous forme de graphes pour quantifier les données collectées.

Peux-tu donner un exemple concret de situation où la qualité des données a fait toute la différence pour un client ?

→ Notre plus gros client, Leroy Merlin utilise la solution Retail Shake pour orienter sa politique de prix et adapter en fonction l’affichage des tarifs en magasin.

La qualité de la donnée impacte directement et concrètement les prix des produits pour le client final.

Comment Retail Shake gère les problèmes de qualité des données, telles que les données manquantes ou erronées ?

→ Il arrive parfois qu’une information essentielle soit manquante. Par exemple des gtins. Dans ce cas, on va chercher à compléter la fiche produit via d’autres plateformes.

Pour les données erronées, nous avons un dispositif (datacrop) entre le processus de collecte et le processus d’injestion en base, dont la fonction est de normaliser et/ou corriger les items. Par exemple, les enseignes n’utilisent pas toutes la même notation pour indiquer les quantités. Certaines vont utiliser ‘kg’ et d’autres ‘kilogramme’.

Quels sont les principaux défis que les clients rencontrent en matière de qualité des données et comment Retail Shake les aide-t-elle à les surmonter ?

→ La veille tarifaire se complique dès lors que le client souhaite comparer des produits type ‘mdd’.

Notre solution propose un mécanisme de matching (à la tinder) qui présélectionne les items candidats à la comparaison.

En quoi la qualité des données que tu fournis contribue-t-elle à renforcer la confiance et la fidélité des clients ?

→ Une bonne qualité des données résulte souvent d’une bonne compréhension des besoins du client. Il se sent en confiance et cela l’incite à plus utiliser notre solution.

Il peut aussi faire des demandes de nouvelles fonctionnalités. Ce dernier aspect est aussi très important pour étoffer notre service.

Comment Retail Shake assure-t-elle la transparence et la traçabilité des données fournies aux clients ?

Transparence : Nous présentons les données au client sur deux modes :

- L’application Retail Shake

- Les exports dans divers formats

Dans les deux cas, le client sait d’où vient sa donnée et quand a-t-elle été collectée.

Traçabilité : Toutes nos données sont horodatées et tracées. Nous savons quel spider a collecté la donnée, à quel moment et à quelle date remonte sa dernière mise à jour.

Quelles sont les technologies ou méthodologies que tu utilises pour garantir la qualité des données et leur pertinence pour les clients ?

→ Je teste actuellement ‘dbt-core’, outil open source pour tester la conformité des données aux exigences clients. La galaxie des outils disponibles est vaste et très dynamique. Je suis en veille constante.

Quelles sont les innovations récentes que tu as introduites pour améliorer encore davantage la qualité des données et répondre aux besoins changeants des clients ?

→ Une version preprod notre orchestrateur de tâches (Airflow) pour la production d’exports à destination de nos clients.

Ainsi, l’équipe tech peut contrôler la qualité des données avant la mise en production. Cette plateforme de préproduction est aussi un genre de bac à sable. L’idée est de permettre de déployer facilement de nouveaux outils directement intégrés à notre workflow.

Conseiller des outils qui facilitent la QA et réduisent les actions manuelles. Par exemple, j’ai proposé à notre CSM Hannah d’utiliser Selenium (https://www.selenium.dev/selenium-ide/) pour enregistrer et rejouer ses actions de vérifications sur les sites que nous scrappons.